[ad_1]

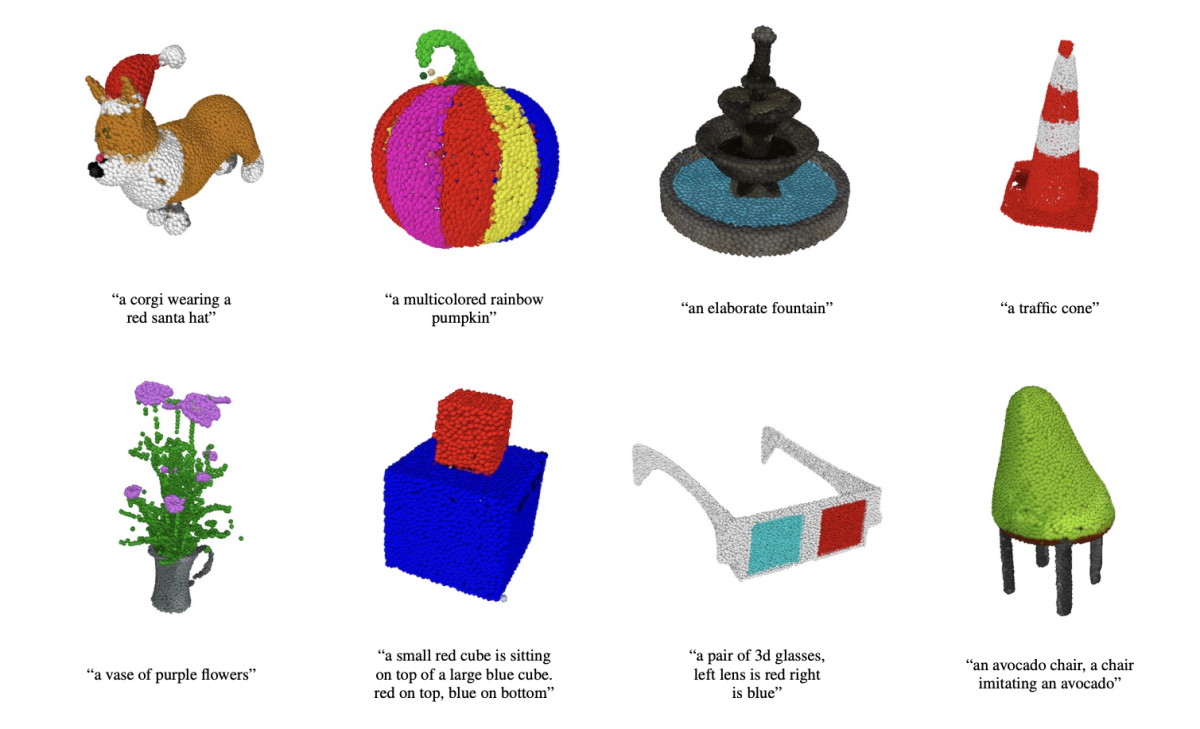

OpenAI dévoile POINT-E, un algorithme comme DALL-E, mais pour les modèles 3D. Et les résultats sont déjà très impressionnants.

OpenAI, la startup d’intelligence artificielle fondée par Elon Musk et à qui l’on doit le générateur texte-vers-image DALL-E si populaire, a annoncé la publication de son nouvel algorithme POINT-E, qui est capable de produire des nuages de points 3D d’après des indications textuelles. Là où les systèmes existants comme Google DreamFusion nécessitent d’ordinaire plusieurs heures et une grosse puissance de calcul pour générer leurs images, POINT-E n’a besoin que d’un GPU et une petite minute de travail.

OpenAI dévoile POINT-E, un algorithme comme DALL-E mais pour les modèles 3D

La modélisation 3D est utilisée dans de nombreuses industries et applications. Les effets CGI des gros films modernes, les jeux vidéo, la VR et l’AR, les missions de cartographie des cratères de la Lune de la NASA, les projets de préservation des sites remarquables de la planète de Google, la vision du métavers de Meta, tous reposent sur la modélisation 3D. Ceci étant dit, créer des images 3D photoréalistes est encore très gourmand en ressources et en temps, malgré le travail de NVIDIA pour automatiser la génération des objets et l’application mobile RealityCapture du studio Epic Games, qui permet à n’importe qui avec un smartphone sous iOS de scanner des objets du monde réel pour en faire des modèles 3D.

Les systèmes texte-vers-image comme OpenAI DALL-E 2 et Craiyon, DeepAI, Prisma Lab Lensa ou encore Hugging Face Stable Diffusion ont rapidement gagné en popularité, en notoriété, mais aussi suscité de vives controverses ces dernières années. Le texte-vers-3D est une extension de ces systèmes. POINT-E, contrairement aux systèmes similaires, “utilise un large ensemble d’associations (texte, image), lui permettant de suivre des indications diverses et complexes, tandis que notre modèle image-vers 3D est entraîné sur une base de données plus restreinte de paires (image, 3D)”, expliquait l’équipe de recherche d’OpenAI dirigée par Alex Nichol dans un papier technique. “Pour produire un objet 3D depuis un simple texte, nous prenons d’abord une image en utilisant un modèle texte-vers-image et ensuite une image 3D à partir de cette image 2D. Ces deux étapes peuvent être réalisées en quelques secondes et ne nécessitent pas de procédures d’optimisation coûteuses.”

Et les résultats sont déjà très impressionnants

Si vous tapez un texte comme “Un chat mange un burrito”, POINT-E va d’abord générer une vue 2D synthétique d’un chat qui mange un burrito. Il va ensuite faire passer cette image à travers une série de modèles de diffusion pour créer le nuage de points RGB 3D de l’image initiale, produisant d’abord un modèle de nuage à 1 024 points, puis un modèle plus fin à 4 096 points. “En pratique, nous partons du principe que l’image contient les informations pertinentes du texte et ne conditionnent pas explicitement les nuages de points dans le texte”, précise l’équipe.

Ces modèles de diffusion ont tous été entraînés sur des “millions” de modèles 3D, tous convertis dans un format standardisé. “Bien que notre méthode soit moins efficace sur cette utilisation que des techniques dernier cri”, admet l’équipe, “elle produit des contenus en seulement une fraction du temps nécessaire à ces mêmes techniques.” Si vous voulez essayer POINT-E par vous-même, sachez que OpenAI a publié le code de ce projet open source sur GitHub.

Source link